はじめに

昨日の12月19日、弊社セミナールームにおいて「AIはなぜその答えを導き出したのか『説明可能なAI』を学ぶハンズオン」というイベントが開催されました。

主催は社内でも機械学習周りに特に強く、講演や書籍執筆、さらにはブログ執筆までこなす、山本和貴さんです。

今回はそのイベントに社内の人間ながらこっそり潜入してきたので、様子ややったことをレポートしていきたいと思います。

当日の様子

「説明可能なAI」とは

今回のセミナーのテーマは「説明可能なAI」です。

そもそも説明可能なAIとは何ぞや?といいますと、AIが行った判断や予測の根拠を後から説明できたり、あるいはそれらの判断基準を説明できたりすることです。

これらのことをそれぞれ「ローカル説明」「グローバル説明」といったりもします。

で、AIの判断や予測の根拠を説明できるといったい何がうれしいのかというと、例えば何かしら重要な判断を行う時(銀行の融資の可否とか医療に関わるよしなしごととか)、その判断をAIに任せるとしてもなぜそのような判断をしたのかという説明をすることができることで、判断に対する信頼度が上がり、AIを用いてこれらの判断を行うことに正当性を持たせることができるようになることです。

何らかの判断を行うタスクにおいてAIを用いる動きは広がってきていますが、その途上には判断の根拠が説明できないという理由で導入が遅れることもあったため、それに答える形で出てきた概念というイメージです。

AutoMLとは

AutoMLとは、Azureの機械学習サービス群の一つで、これらの中でも特に初心者でも触りやすいものという位置づけにあります。

これを用いることで、機械学習のモデリングに精通していないような人でも自動で作成されたモデルを用いて精度の高い分析を行うことができます。

Azure Learn上にも、Azure Machine Learning Serviceに関する教材があるので、初めての方はここから試してみるのもいいかもしれません。

ハンズオン

前座はこの辺りにして、本題に入りたいと思います。

実際、今回のセミナーの大半はハンズオンに充てられていました。(ハンズオンセミナーなので当然といえば当然)

大半の時間説明を聞いて途中or最後に少しだけ実際にそのサービスを触ってみるというのではなく、大半の時間を実際に触ってみて、それによって知見を深めようという会です。

以前参加したGlobal AI Nightも似たような形式でしたね。

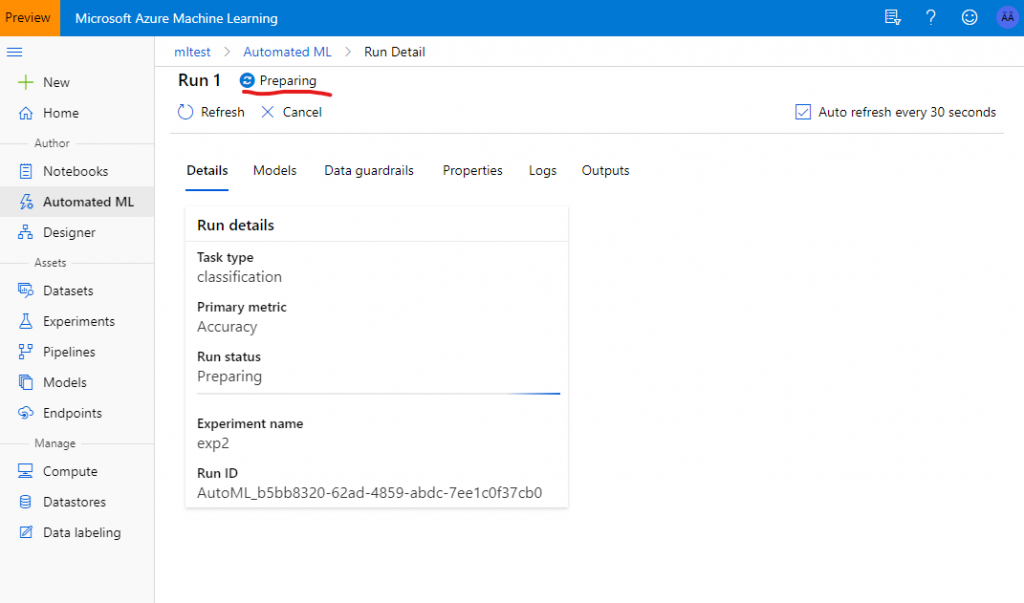

ハンズオンで行ったこととしては、機械学習モデルを作るところまではこれまでも参加した機械学習ハンズオンでやってきたようなコンピュータクラスタを立ち上げてデータをアップロードして分析をかけるというものでした。

やり方としてはこの辺りのドキュメントを参考にすればできそうです。

データとしては銀行の融資に関するもので、顧客の年齢や残高などから、融資が許可されたかどうかの分類を行うモデルを作成するハンズオンを行いました。

今回のハンズオンの目玉は、なんといってもその作成したモデルの判断の根拠を確認できるということでした。

。。。といっても、私の手元ではなぜかモデル作成がPreparingから完了に変わらず、セミナーの後帰ってから何度か試してもモデル作成で躓いてしまい、実物を見ることはできませんでしたが・・・残念。

もしもモデルが作成できたら、そのモデルのページの「Explanation」タブから、データセットのどの要素が融資の可否に強く影響するかが影響度合いを示す棒グラフで確認できるようです。

これによって、「融資の可否に強く影響する要素は何か?」とか「なぜ私は融資を許可された(されなかった)のか?」といった問いに答えることができるようになります。

銀行で融資の受付をする方も説明に困らなくなりますね!

おわりに

今回は弊社セミナールームで行われた社外勉強会についてレポートしてきました。

和貴さんはこれまでも何度もセミナーを主催してきたということですが、さり気に自分が参加したのはこれが初めてだったりします。

これからも何かしら開催されることがあればぜひ参加してレポートしていきたいと思います!

![Microsoft Power BI [実践] 入門 ―― BI初心者でもすぐできる! リアルタイム分析・可視化の手引きとリファレンス](/assets/img/banner-power-bi.c9bd875.png)

![Microsoft Power Apps ローコード開発[実践]入門――ノンプログラマーにやさしいアプリ開発の手引きとリファレンス](/assets/img/banner-powerplatform-2.213ebee.png)

![Microsoft PowerPlatformローコード開発[活用]入門 ――現場で使える業務アプリのレシピ集](/assets/img/banner-powerplatform-1.a01c0c2.png)