こんにちは、早い所で新しいCognitive Servicesの発表からもう1ヶ月経とうとしています。

今回は今年5月にpreview版が発表された、Video

Indexerで日本語の動画がどの程度使えるのか試してみました。

そもそもVideo

IndexerとはBuild

2017で発表された、新しいMicrosoft

Azure Cognitive Servicesです。

動画をVideo

Indexerにアップロードすると、話している人の判別や内容のテキスト化、キーワードの抽出などを自動で行ってくれて分析結果の公開まで出来るサービスです。

サンプルには既に英語の動画(build 2017のkeynoteなど)が有るので、今回はサインインから動画のアップロード、簡単な機能確認辺りまで、日本語の動画で色々試してみたいと思います。

1.サインイン

1.兎にも角にもまずはサインインですね。

MicrosoftのCognitive

Servicesのページから、Video

Indexerのページに飛んで緑四角の「はじめる」を押してもらうか

Cognitive Serviceのページ

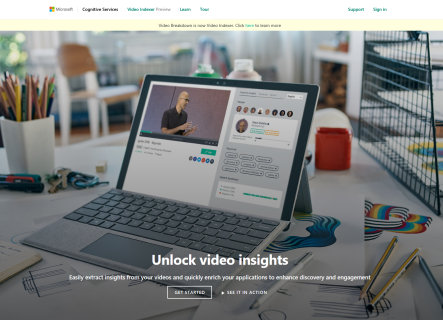

下記のリンクを押すと、Video Indexerのポータル画面に飛びます。

Video

Indexerポータルページ

https://vi.microsoft.com/

Video Indexerポータルページ

2.白線の四角に囲まれている、「GET STARTED」をクリックします。

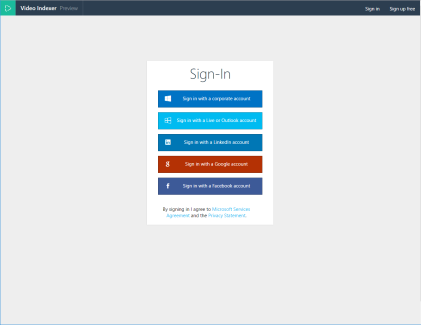

すると、アカウントの選択画面が表示されるので、お持ちのアカウントでサインインしましょう。今回、私はoutlookアカウントでサインインしました。

サインインアカウント選択画面

現状サインイン可能なアカウントは

・コーポレートアカウント

・マイクロソフトアカウント(旧liveアカウントやoutlookアカウント)

・LinkedInアカウント

・googleアカウント

・Facebookアカウント

の5種類です。

2.動画のアップロード

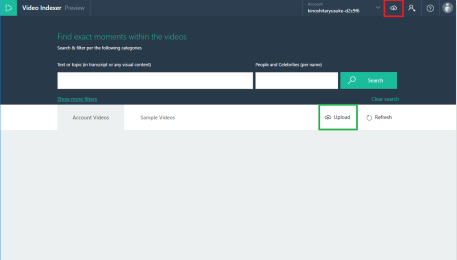

サインインに成功したら、下記の様なTOPページに行くと思います。

Video Indexer TOPページ

1.動画をアップロードするには、画面上部の右側で赤枠に囲まれている部分か、中央右側の緑枠に囲まれている部分をクリックします。

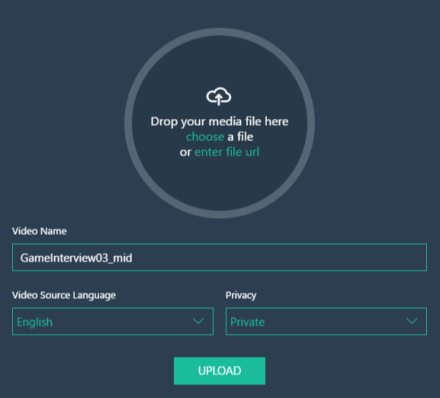

クリックすると画像の様な動画のアップロード画面に行きます。

動画アップロード画面

画面中央の円の中に動画ファイルをドラッグ&ドロップするか、緑字の「Choose」の部分をクリックするとローカルに保存されている動画が選択、「enter file URL」をクリックして動画ファイルのURLを入力すると動画のアップロードが出来ます。

今回使用した動画はChannel9からダウンロードしてきた、日本語のインタビュー動画です。(特にこれと言った選定理由は無いのですが…)

セガゲームス コンシューマ・オンラインカンパニー 瀬川 隆哉 氏 & 酒井 智史 氏インタビュー

https://channel9.msdn.com/Series/win-game/game-interview-03

2.用意した動画を挿入すると下記の様な動画情報の入力画面がでます。

動画ファイルの情報入力画面

3.Video NameはそのままでVideo

Source LanguageについてはJapaneseを、PrivacyについてはPrivateを設定しました。

Languageについては英語やフランス語、ポルトガル語に中国語など9種類の言語から選択出来ます。

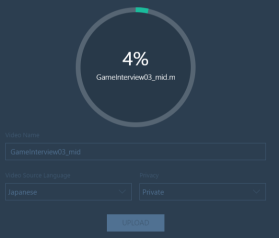

4.アップロードを行うと、アップロード完了までの待機時間と分析完了までの待機時間が有ります。回線にもよるかと思いますけど、大体20分のインタビュー動画で345MB のファイルをアップロードするのに4分程、分析が完了するのに10分程かかりました。

アップロード中の画面

3.アップロードした動画の確認

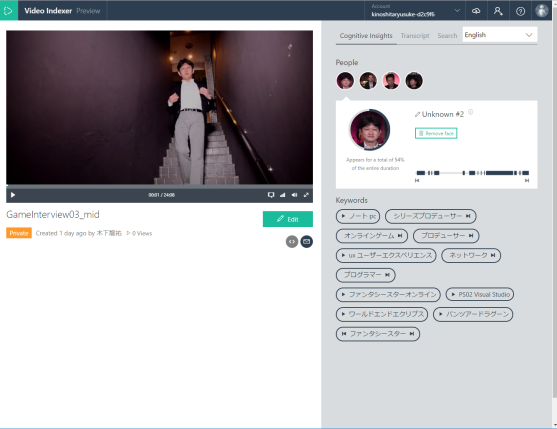

1.動画の分析が終了すると下記の画像の様になります。

アップロードした動画の実行画面

この時点で既に右側に何となく話している人とキーワードが、抽出されているように見えますね。

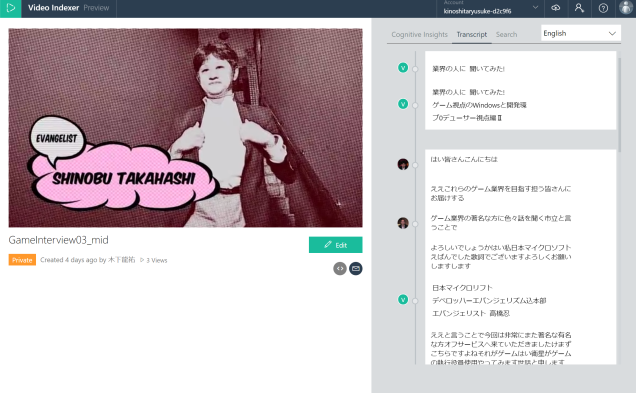

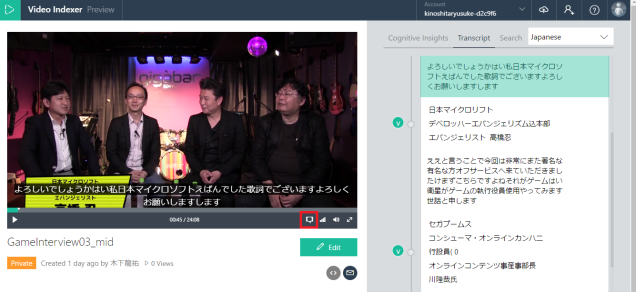

2.画面中央上やや右にある「Transcript」をクリックすると、話してる内容や動画内で表示された文字がテキスト化されているのを確認できます。

動画内容のテキスト表示画面

パッと見た感じ、結構日本語の話してる内容をテキストに出来てるなという感じです。とは言え、やはり課題になっている同音異義語など誤変換も結構見つかるので、もう少し頑張ってねと言う評価ですね。

右上のコンボボックスで言語を選択して翻訳出来るのですが、ファイルをアップロードする際に選択したVideo Source Languageで分析結果が出ているのに関わらず、デフォルトがEnglishになっているのが少し不便…

字幕の表示

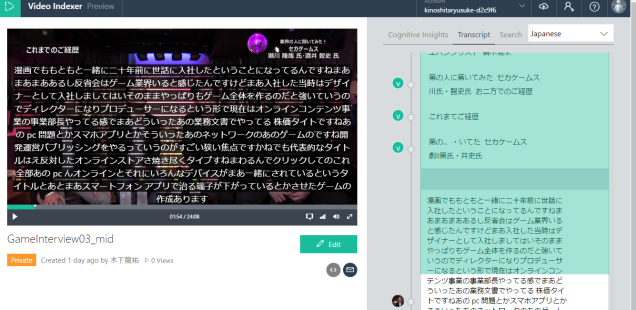

3.下の画像の赤枠内をクリックしてもらうと話してる部分に対応した字幕を表示出来ます。テキストにした分析結果を翻訳した内容も字幕として表示出来たりして、とっても便利!

と思ったりもしたのですが、日本語の内容は文の切れ目がまだ正常に理解出来ないらしく1人が長文を話してると画面を覆う程の字幕が表示されかなり見にくい…

日本語特有?の字幕

話してる部分に応じてシークする、画面右側緑で囲まれたの分析結果のところの挙動もなんかおかしいですね。

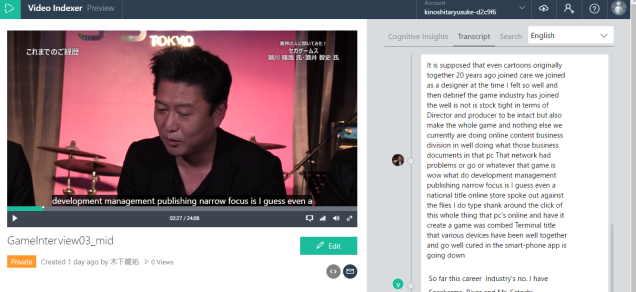

4.同じ部分を英語翻訳して、字幕を表示するときちんと1行ずつ表示されています。

英語などで同じ部分を映すと正常

まだまだ書いていない機能は多く有るのですが、とりあえず今回の記事はここまでです。

アップロードだけしてみて確認する感じだと、英語の動画の日本語訳はあまり使えたものでは無い状態で、日本語の動画の分析結果もあと一歩精度を高めてほしいと言った所です。

Cognitive Servicesは通知など出さずに、気付いたらバグ対応などの更新がされているという事が結構多いです。そのため、後半に書いた日本語の字幕の挙動など含めて改善される日もそう遠くないのかもしれませんね。

とりあえずは、今回の記事の続きやCustom Vision Service、少し前に新しいUIになってるLUISなどを触りながら諸々の更新を待っていようかと思います。

![Microsoft Power BI [実践] 入門 ―― BI初心者でもすぐできる! リアルタイム分析・可視化の手引きとリファレンス](/assets/img/banner-power-bi.c9bd875.png)

![Microsoft Power Apps ローコード開発[実践]入門――ノンプログラマーにやさしいアプリ開発の手引きとリファレンス](/assets/img/banner-powerplatform-2.213ebee.png)

![Microsoft PowerPlatformローコード開発[活用]入門 ――現場で使える業務アプリのレシピ集](/assets/img/banner-powerplatform-1.a01c0c2.png)