こんにちは

以前書いた記事から、ちょくちょくVideo Indexerを触っているのですが、こちらの想定している動きをしない部分が有ります。

[Cognitive Services]Video Indexerで日本語の動画が、どの程度分析出来るか試してみました。

http://wp.me/p7xtQO-dSF

前回の記事で既に一箇所、日本語の字幕を表示しようとすると、適切に区切られずに字幕が画面を埋め尽くす事について書いているのですが、今回もその部分に近い問題です。

大まかにタイトルに書いてある通りなのですが、Video IndexerでSpeech Sentiments(話している内容についての感情)が日本語の動画だと全く解析出来ないんです…

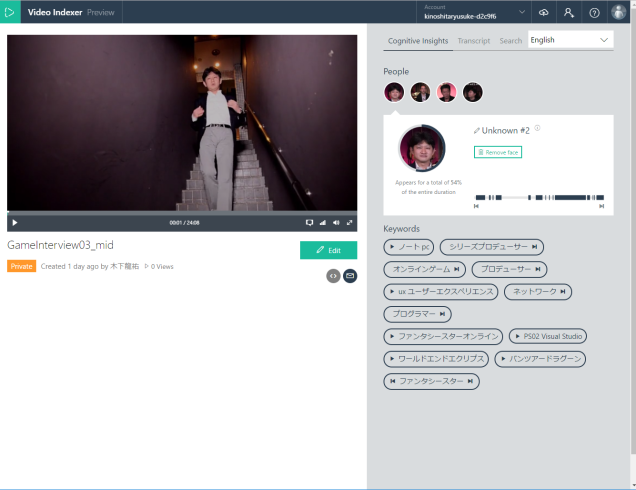

日本語動画のpreview画面

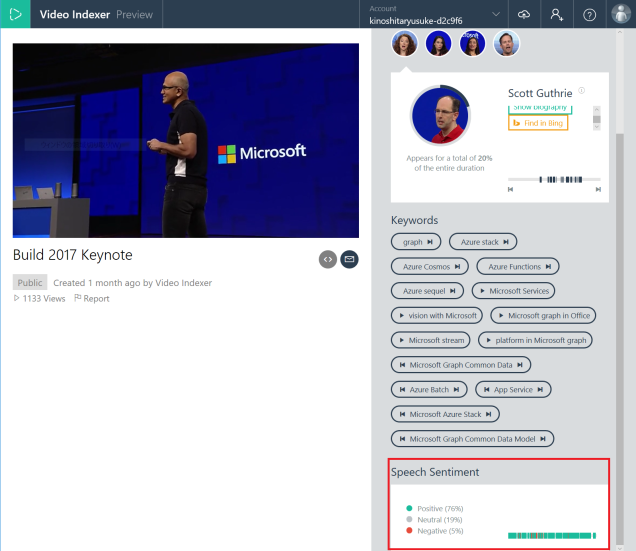

英語(サンプル)の動画のpreview画面

2枚の画像を見てもらえると分かるように日本語の動画(Video Source Language = Japanese)だと、右下にSpeech Sentimentの枠自体存在しないんですよね。

少し調べた感じですと、Cognitive Servicesの一つで文章からキーフレーズやSentimentの分析を行うText Analytics APIでも日本語のSentimentは判断出来ない様です。

文章だけならMicrosoft Translatorを使って日本語を英語にしてから判断させたりと、やりようは有る様ですが、動画をアップロードする形のVideo Indexerでは、そういうやり方も難しそう…

Transcriptの言語を英語にしてもSentimentsを判断してくれないので、アップロード時のVideo Source LanguageがJapaneseの時点でSentimentは全く機能しなくなってしまうんですかね?

取り合えずはText Analytics APIのSentiments判断が日本語対応するのを待つしか無いのですかね…

Video Indexerで日本語の動画のSentimentsを解析出来る方法を知っている方コメント待っています!

![Microsoft Power BI [実践] 入門 ―― BI初心者でもすぐできる! リアルタイム分析・可視化の手引きとリファレンス](/assets/img/banner-power-bi.c9bd875.png)

![Microsoft Power Apps ローコード開発[実践]入門――ノンプログラマーにやさしいアプリ開発の手引きとリファレンス](/assets/img/banner-powerplatform-2.213ebee.png)

![Microsoft PowerPlatformローコード開発[活用]入門 ――現場で使える業務アプリのレシピ集](/assets/img/banner-powerplatform-1.a01c0c2.png)