はじめに

AI系が好きで勉強中の佐藤です(ちなみに最新の案内AIちゃんとのお話の話はこちら)。

今回はこの記事で紹介されていた、Microsoftが12月3日に日本語版リリースをしたSeeing AIを試してみたので、そのレポートをお送りします。

ちなみにこの公式ページ(Seeing AI)にはデモ動画がたくさん上がっているので、そちらもぜひ参照してみてください。

さっそく使ってみた

アプリを起動すると、カメラが起動して、現在何のモードになっているかが読み上げられました。

いくつかモードを選択して、解析してもらうもののようなので、それぞれ個別にレポートしていきます。

短いテキストモード

テキストの上にカメラをかざすと自動的に読み上げられるモードです。

以下の画像で試してみました。

こちらは「しょうがいしゃのめ マイクロソフトのシーイング アルのしくみをかんがえつつ ちょっとつかってみた ぜろ ぶんしょうをにゅうりょく またはすらっしゅでぶろっくをせんたく」と読み上げられ、AIが「アル」と読み上げられたり、記号が「ゼロ」と読み上げられたりしましたが、概ね正しく読み上げてくれました。

ロゴっぽい文字も読めるかどうかが気になったので、手元にあったコミックマーケットのリストバンドを写してみました。

こちらは横線がピリオドと認識されてずっとピリオドとループした後に、「コミックマーケット アドミッションリストバンド きゅうじゅうなな」と読まれました。

ロゴっぽいものも読めますが、周りのデザインなどが障害になってしまうようですね。

製品モード

バーコードの上にカメラをかざすと、製品名が読み上げられるモードです。

近くにあったティッシュを読み込ませてみました。

すると、右端の方に見えるように「Nepia Crecia Scottie - 200」と製品が読み上げられました。

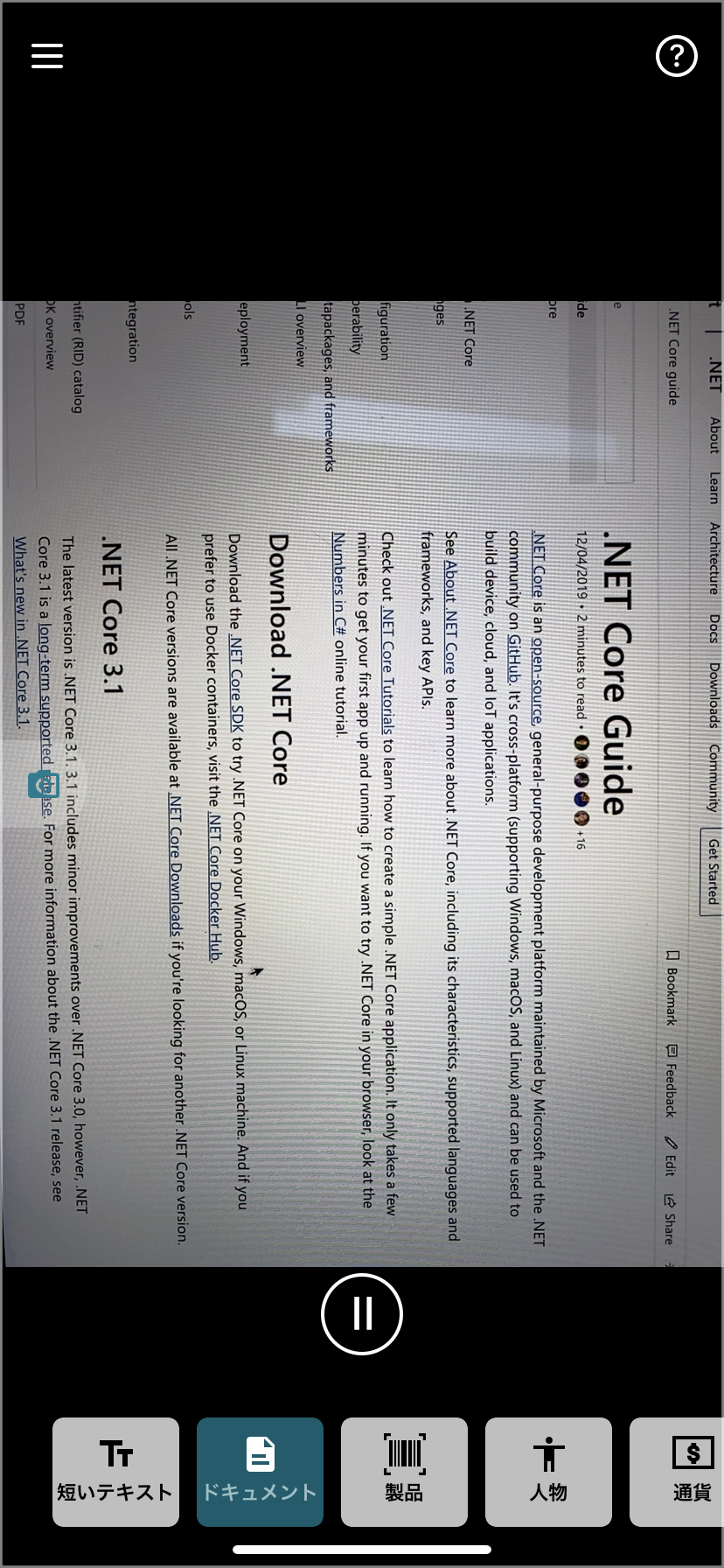

ドキュメントモード

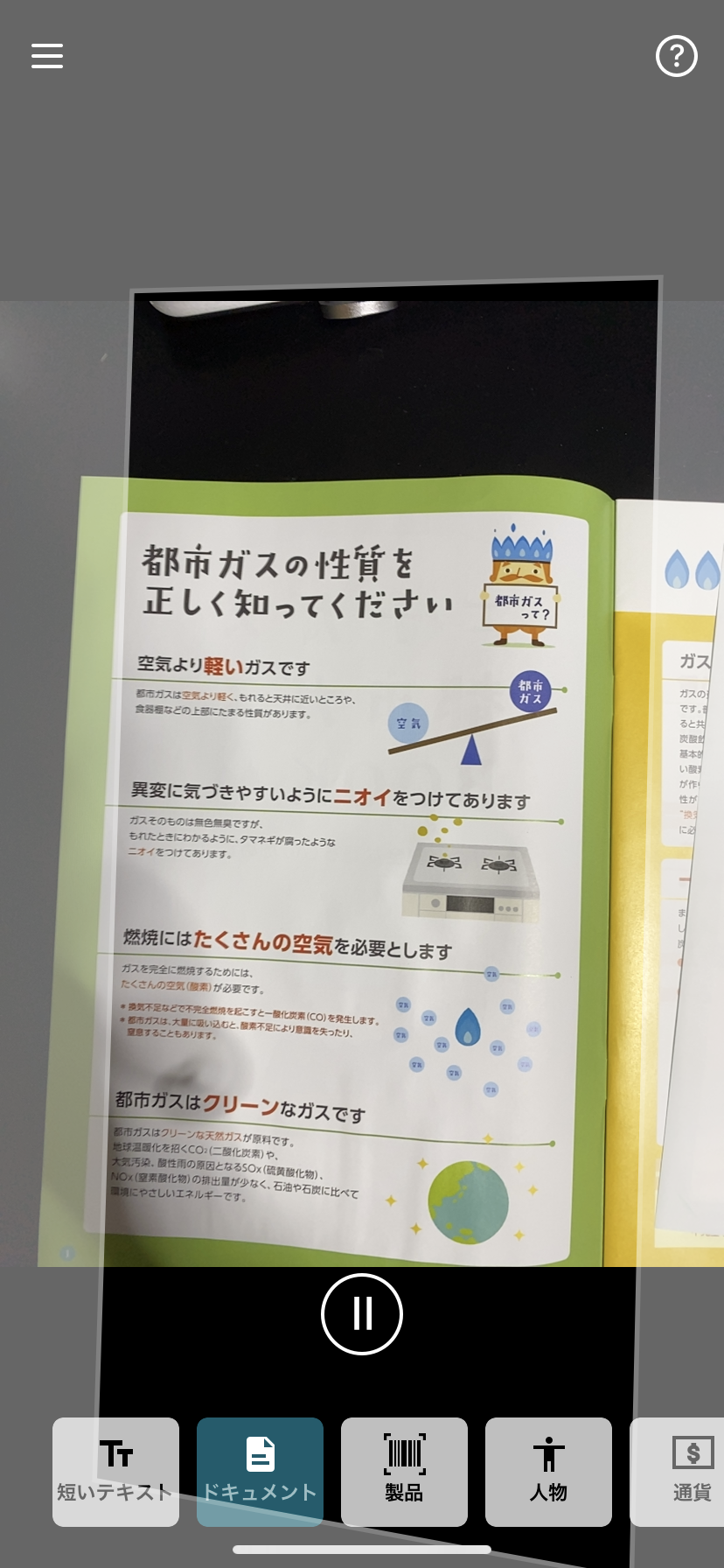

印刷されたページにかざすとキャプチャされて、テキストが認識され、読み上げられるモードです。

ポストに入っていたチラシで試してみました。

キャプチャされてしばらく経つと、このような結果が帰ってきて、青くハイライトされた部分が読み上げられつつ下に移っていきました。

飾り文字やフォントなどが変わっていたためか、大きめの見出しはちゃんと認識できなかったり、その周りもつられて認識できなかったりなど不完全な面が目立ちました。

そこで、もう少し書類っぽい日本語のドキュメントならうまくいくのではないかと試しました。

こちらはキャプチャし忘れてしまったのですが、たまに中国語っぽい文字が混じったり、「赤(あか)」を「せき」と読んだりするものの、上のキャプチャよりはうまく認識してくれました。

そのため、「日本語の文字種類の多さが原因なので、英語のドキュメントだったら一番うまくいくのではないか」と考えて、したのドキュメントを読み込ませてみました。

すると、専門用語などがたまにうまく認識できていないものの、一番よく認識してくれました。

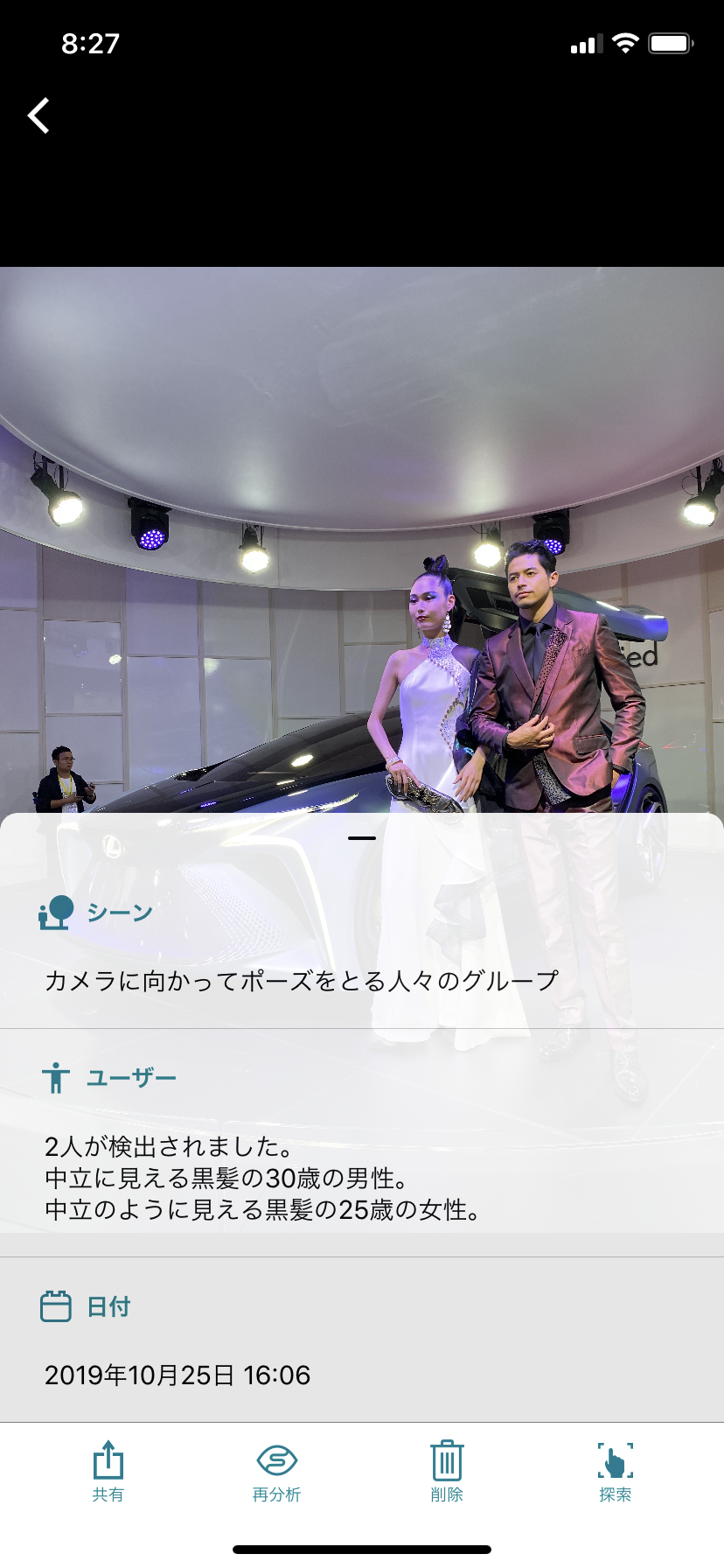

写真の参照

こちらは写真を読み込ませると、物・人・テキスト、場所がないかをまとめてみてくれるモードです。

東京モーターショーの写真を読み込ませたところ、シーンモード・人物モードで解析を行った結果が帰ってきました。

ちなみに撮影する人物モードはキャプチャし忘れたのですが、認識される人数や性別は結構正確でした。

ライトモード

こちらは周囲の光の量によって音の高さが変わるモードです。

撮影するのが難しかったため、説明文のキャプチャのみですが、明るいところでは高い音、暗いところでは低い音が聞こえました。

通貨モード

こちらは試せなかったため、説明文のキャプチャのみとなりますが、紙幣の金額を推定してくれるようです。

色モード

こちらは認識した色を読み上げてくれるモードです。

下の画像のようにスポイトマークがある四角の部分に色を写すと「ピンク、赤」と言ったように色を読み上げてくれます。

![Microsoft Power BI [実践] 入門 ―― BI初心者でもすぐできる! リアルタイム分析・可視化の手引きとリファレンス](/assets/img/banner-power-bi.c9bd875.png)

![Microsoft Power Apps ローコード開発[実践]入門――ノンプログラマーにやさしいアプリ開発の手引きとリファレンス](/assets/img/banner-powerplatform-2.213ebee.png)

![Microsoft PowerPlatformローコード開発[活用]入門 ――現場で使える業務アプリのレシピ集](/assets/img/banner-powerplatform-1.a01c0c2.png)