この記事では、私が誰で何をしていたのかを紹介します。

私のプロフィール

始めまして。岡見 洋佑(おかみ ようすけ)と言います。

この度奈良先端科学技術大学院大学からFIXERに入社しました!

香川のそこそこな大きさの島である小豆島出身です!

突然ですが、数年後に社会的に普及しそうな技術って興味ないですか? 特に技術を使用した機械ってワクワクしませんか?

私はその中でも、拡張現実感(AR)と自動運転車という2つが直近で社会実装されると思い、興味を持ったので研究テーマにしました。

※以下の内容は奈良先端科学技術大学院大学(NAIST)の成果になります。

自動運転の車ってなんか怖いよね

現在、様々な自動車メーカーがオートパイロットや運転サポートといった機能を搭載した自動車を販売しており、運転手の不要な車がいつ出てきてもおかしくない時期になってきています。

でも、自動運転の車ってなんだか漠然と怖くないですか?

自分が購入した車が事故を起こしたとき、責任や車の保証は誰がするのか、せっかく購入した車が事故を起こすのは嫌じゃないですか?

タクシーに乗るのと違ってなぜか怖くないですか?

自動走行システムに対して信頼をすることはできますか?私は怖いし、信頼できないです。そこで、なんで怖いのか、どうすれば解決できるかについて研究をしていました。

自動運転ってどんなものがあるの?

自動運転は運転手のサポートをするものから、運転手の代わりにシステムが運転するものまで幅広くあります。

自動運転車って6段階に分けられていることは知っていましたか?

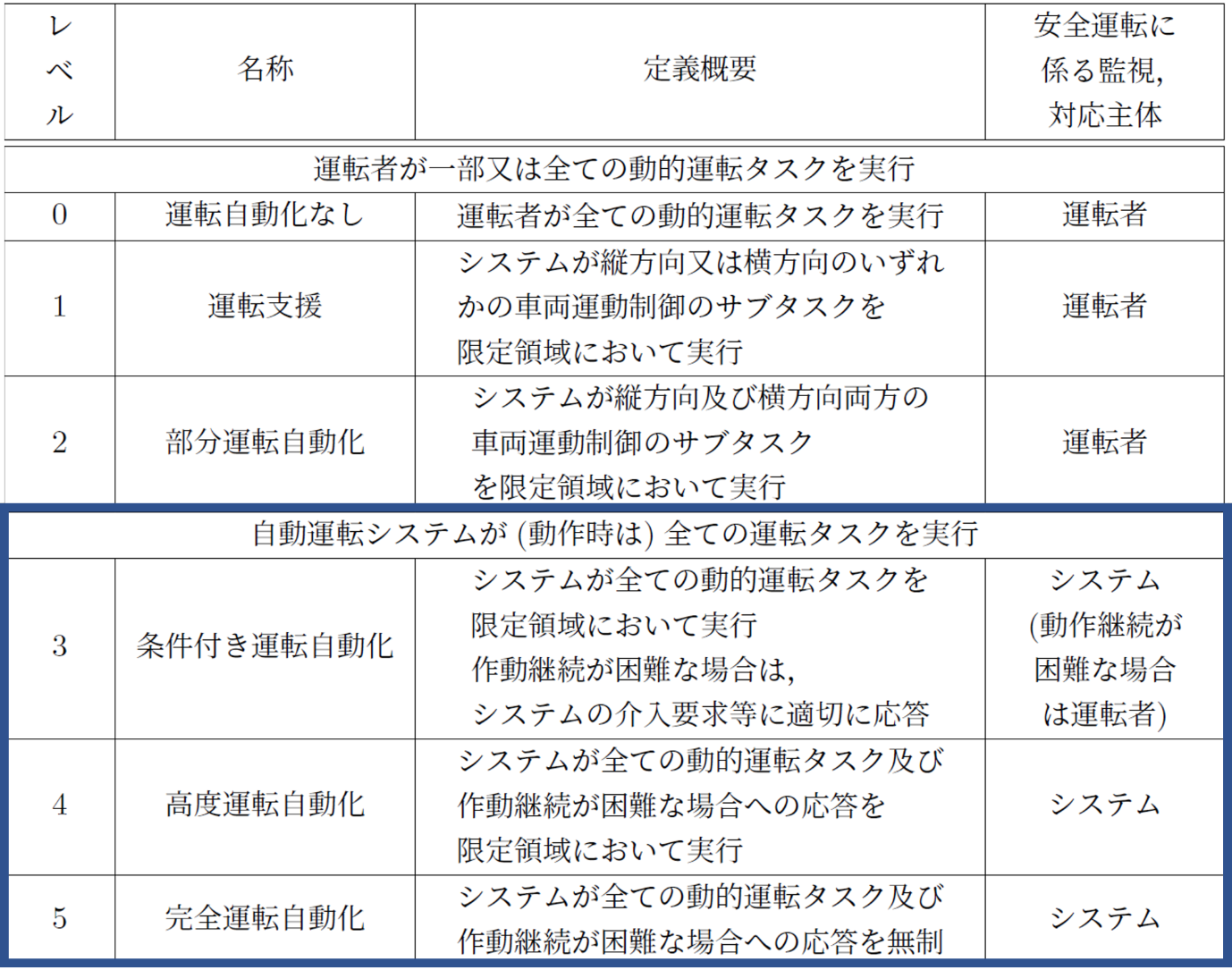

アメリカの自動車技術会が公表している自動運転のレベルの定義があります。

日本では国土交通省が独自に定めたものがあります。 その図下に貼っておきます。

この図で示されている通り、レベル0~2では人が主体となって運転をしており、3~5ではシステムが主体となって運転をしています。

私の研究では、このレベル3~5を対象としています。

じゃあ、自動運転でのストレスって何?

レベルがいっぱいあるのは分かったけどストレスってどんなのがあって、なんで発生しているの?ってことについて説明していきます。

自動運転のレベル3~5では、システムが主体となって運転するため、これまで運転手だった人が運転から解放されて搭乗者となります。

でも、運転から解放されたからといって、周りを気にせずにすぎにスマホを操作したり、寝たり、映画を見たりしますか?

システムの運転が怖くて、車外環境を見ながら、いつでも緊急停止ができるように構えませんか?

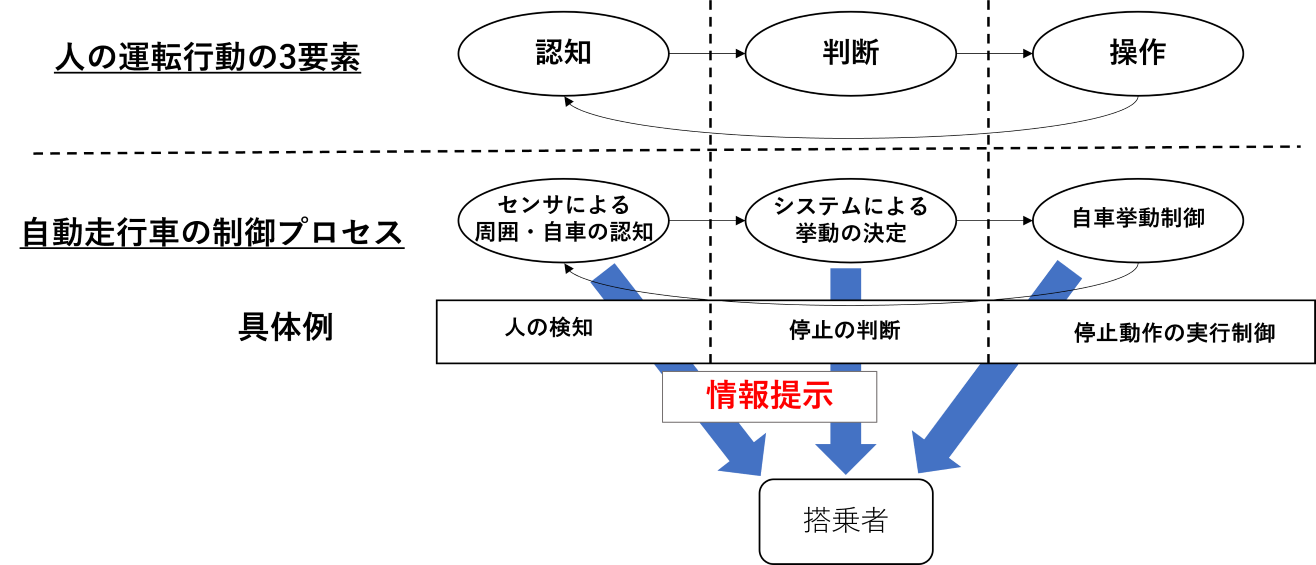

このような不安が何から来ているのかを運転行動と呼ばれる、人が運転を行う際に考えていることや動作を分類したものを基に考えました。

そして、下図に示すように、人で言うところの認知と判断について搭乗者に対して情報共有されていないもしくは不十分なことがストレスの原因となっていると仮説を立てました。

提示した情報はどんなもの?

認知や判断の情報を提示するといってもどんなときにどんな情報を提示するのか?

まず、判断では、自動走行車の将来の走行経路がわからないことから来るストレスを対象として、走行経路や右左折および旋回のタイミングを知らせることでストレスの軽減を図ろうとしました。

もう一つの認知では、工事エリアの回避や人の飛び出しを想定して、何を認識して、回避行動をとるのかについて知らせることでストレスの軽減を図りました。

そして、アイキャッチの画像について気になっていた人もいると思いますが、これから説明していきます。

情報を知らせる手法ってどんなものがあるでしょうか?音?動画像?それらもいいですね。

でも、走行経路や検知した障害物の場所をもっと直感的に知らせる方法にARがあります。

そこで私の研究ではARを用いた情報提示手法と従来のよく使われている音での情報提示の比較を行いました。

アイキャッチ画像は走行経路を示したもので下に工事エリアを検出して、経路変更した際の画像を置いておきます。

実験の結果については聞かないでください(苦笑)作りこみが甘かったせいなのかな?なんなら実験中にシステムがうまく動かない時もありました。

使用したソフトウェア

使用したソフトウェアは次に表に載せます。

| 会社 | 商品名 |

| 株式会社ZMP | Robocar Minivan(自動走行車) |

| MIcrosoft | HoloLens2 |

次に使用したソフトウェアを紹介します。

| 会社 | ソフトウェア名 |

| Unity Inc. | Unity2020.3.39f1 |

| ------ | Python 3.10.9 |

| Canonical Ltd. | Ubuntu 16.04 |

| The Autoware Foundation | Autoware.ai |

使用したライブラリおよびミドルウェアは以下になります。

- MixedRealityToolKit v2.7.0(UnityでHoloLens2を使用するためのミドルウェア)

- ROS(ロボットを動かすためのミドルウェア・AutowareがROSベースで作られているため使用)

- Roslibpy(ROSデータをWindowsで受け取るためのPythonライブラリ)

- Google text to Speech(音声合成ツール)

- ros bridge(ROSのデータを別PCで送受信するためのライブラリ)

苦労したポイント

まず、自動走行車を研究室で初めて取り扱うため、データの送受信方法もわからず、私自身がROSを取り扱ったことがなかったため、ROSについて勉強をしたこと、自動走行車の制御PCのバックアップPCの準備に手間取ったこと、システム構成をどのようにすればよいのかわからないといったことに苦労しました。

中でも、自動走行車の中でAR ヘッドマウントディスプレイを取り扱う際に、車の中でのヘッドマウントディスプレイがどこにあるのかという、自己位置推定にずれが発生するという問題や、位置合わせが難しかったです。しかし、この問題についてはMicrosoftがアップデートで移動プラットフォームモードというものをHoloLens2の機能として実装していたため、少々不安定ながらも移動中の車内で利用することができました。

最後に

自動運転って周りや障害物をきちんと認識しているのか、どこを走るのかわからないため、私は怖いと感じています。慣れてしまえば問題ないのですが、なれるまでに時間がかかり、社会的普及の妨げになるだろうと考えています。この研究については研究室の後輩が引き継いでいてより良いものを作ってくれていることでしょう!!!

改めて23年度新入社員の岡見と申します。よろしくお願いいたします!

![Microsoft Power BI [実践] 入門 ―― BI初心者でもすぐできる! リアルタイム分析・可視化の手引きとリファレンス](/assets/img/banner-power-bi.c9bd875.png)

![Microsoft Power Apps ローコード開発[実践]入門――ノンプログラマーにやさしいアプリ開発の手引きとリファレンス](/assets/img/banner-powerplatform-2.213ebee.png)

![Microsoft PowerPlatformローコード開発[活用]入門 ――現場で使える業務アプリのレシピ集](/assets/img/banner-powerplatform-1.a01c0c2.png)